声が瞬時に文字になる! AIで変わる日本の働き方

2019/07/31 Toshiba Clip編集部

この記事の要点は...

- 会議や講演などの音声を高精度にテキスト化し、字幕表示できる新技術が完成

- 新しいモデルとディープラーニングの組合せで極めて高い再現率を実現

- オフィスだけではなくモノづくりの現場でも生産性向上の期待がふくらむ

「人生100年時代」がすぐそこまで迫る今、少子高齢化による人手不足と、働き方改革による生産性向上を同時に解決する手段として、ロボットで業務を自動化するRPA(ロボティクス・プロセス・オートメーション)が注目を集めている。金融業界をはじめ様々な分野で導入され、書類の作成やデータの入力作業が自動化されるなど大きな成果を挙げている。

ところが、どんな業界にも共通する会議の議事録作りや講演の文字起こしなどの作業だけは、なぜかマンパワーに委ねられたままだ。もちろん音声を自動でテキスト化するAIやソフトウェアは既に販売されている。しかし正確なテキスト化は想像以上に難しく、結局マンパワーで手直ししなくてはならないのが現状だ。

この課題を解決し、働きやすい社会づくりに貢献することはできないか?――東芝が出した答えは、新たに開発した音声認識AIだ。

開発した株式会社東芝 研究開発センターの芦川氏、藤村氏に、音声認識AIが求められる背景、開発のブレイクスルーを聞いた。

音声をスムーズに文字起こしし、見やすい字幕でスピード表示!

東芝は、人の声や画像を知識処理して活用するメディアインテリジェンスに取り組んできた。この音声認識AIにも長年にわたって培われてきた開発基盤が大きな役割を果たしている。

開発を検討し始めたのは2015年のこと。折しも、世の中では障がい者でも様々な情報にアクセスし、入手しやすい環境を目指す「情報アクセシビリティ」を整備する機運が高まっていた。一方東芝では、障がいのある従業員が商品開発に参加できるユニバーサルデザイン(UD)・アドバイザー制度を設けており、かねてからUDに配慮した製品やサービスの開発に取り組んでいた。

「聴覚障がい者の方にヒアリングしてみると、会議や講演の内容を事後に書き起こしとして見るのではなく、リアルタイムに参加していきたいというニーズがあることがわかりました。そこで、読みやすいリアルタイム字幕を自動的に表示する機能の導入を目指したのです。障がい者の情報収集・提供をサポートする『情報保障の拡大』と『生産性の向上』。この2本の柱から音声認識AIの開発はスタートしました」(芦川氏)

株式会社東芝 研究開発センター メディアAIラボラトリー 研究主務 芦川平氏

音声認識率85%をクリア! 精度を支えるテクノロジーとは

人の会話、講義や講演の発話をすべて忠実にテキストに起こすと、かえって読みにくい文章になってしまう――文字起こしを経験した方ならお分かりだろう。「えー」「あのー」といった意味のない言葉であるフィラーや内容に何ら影響のないあいづちなど、情報を読み取る上では不要な内容が多く含まれているからだ。

今回の音声認識AIは、話し手の声を高精度に認識し、フィラーや言いよどみも検出することができる。生産性向上を目指すにあたり、これは欠かせない機能になる。AIのコアになるのはアルゴリズム。この精度を向上させるべく、開発チームは様々なアプローチを模索したという。

「当初は認識の精度がなかなか高まらず、壁に突き当たったこともありました。しかし、私たちが進めるべきは開発のための開発、研究のための研究ではありません。あくまでユーザーに使っていただき、利便性を提供することが第一義です。ポピュラーになりつつあったLSTM(注1)というモデル、そしてCTC学習(注2)を用いることで、人間特有のフィラー、言いよどみなどの音響的な特徴の学習を目指していきました」(藤村氏)

(注1)LSTM (Long Short-term Memory):隠れ層に再帰構造のあるRNN(Recurrent Neural Network)の発展形の一つ。従来のRNNでは困難とされていた長期の依存関係を学習可能にする。

(注2)CTC(Connectionist Temporal Classification):空文字の導入と損失関数を工夫することにより、入出力で系列長が異なる問題に対してRNNを導入するための手法。

株式会社東芝 研究開発センター メディアAIラボラトリー 主任研究員 藤村浩司氏

これまでの音声認識では、音の波形を分析してこの部分が「ア」、この部分が「イ」といった具合で指定しながら解析をしていたという。しかし、フィラーも言いよどみも無数のパターンがあり、一つひとつを学習していてはきりがない。

「フィラーとはこういうものである、言いよどみとはこのように言葉に詰まる感じである、ということをLSTMによって統計的なモデルとして捉え、CTC学習によってモデルとして学習させるようにしたのです。これにより、無数のパターンがあるフィラー、言いよどみも検出できるようになっていきました。

もちろん、完璧な精度の音声認識というものは、どの企業も開発できていません。まだまだ開発の幅、目指すべき技術の高みは残っています。私たちの音声認識も日本語、英語、中国語に対応していますが、究極的には、多言語の話者が一つのテーブルに集まってもスムーズな対話が楽しめるもの。SFやマンガに出てくる未来を現実のものにしてしまう精度、機能を目指せたら……そう夢見ながら開発にあたっています」(藤村氏)

この動画は2019年3月14日に公開されたものです。

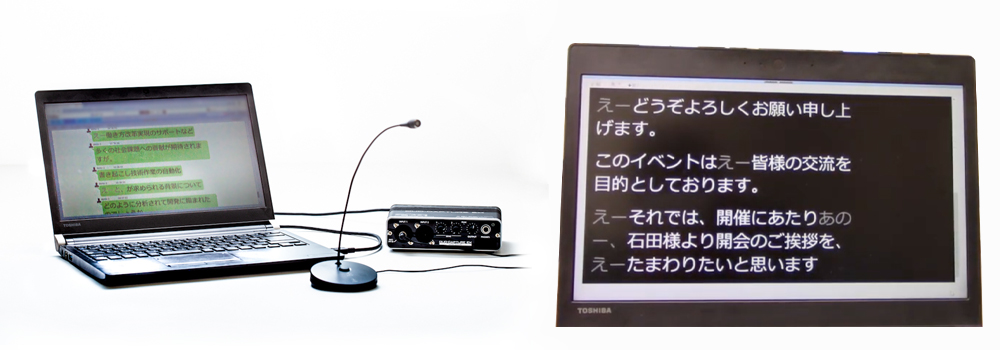

こうして、認識精度で高い優位性を持つ音声認識AIへと進化した。外部の講演の機会を利用して実証実験を行ったところ、音声認識率は平均で85%を達成。編集や事前学習なしで発言内容を把握できる一定以上のレベルがクリアできたという。音声認識の精度を上げたことで、コミュニケーションAI「RECAIUS™」への活用も検討していく。

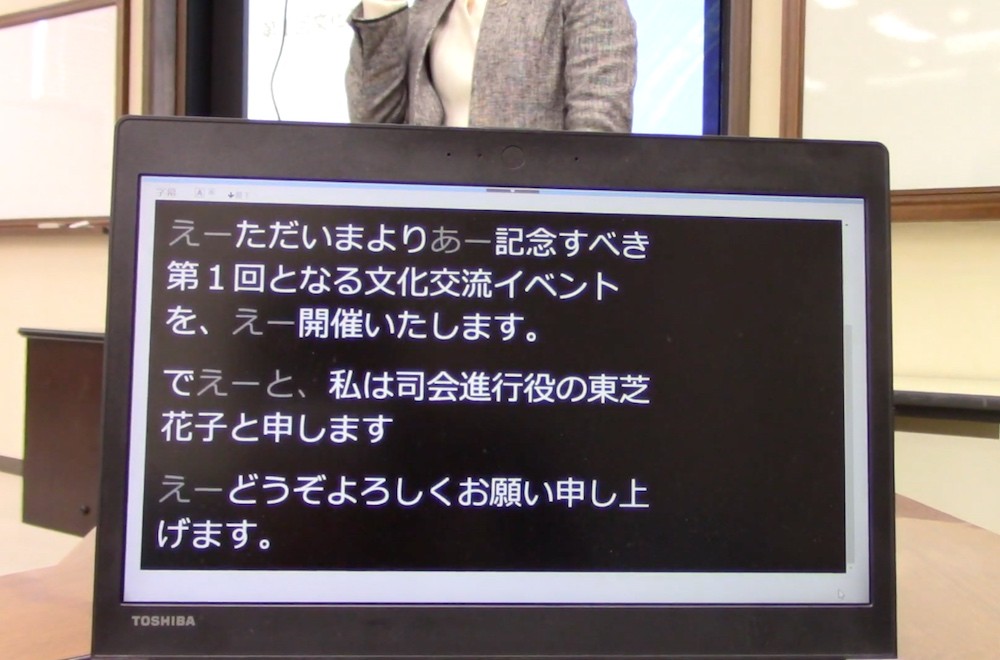

並行して、アプリケーションの開発も進められた。代表的なものが聴覚障がい者に向けたリアルタイム字幕表示機能である。AIが検出したフィラーや言いよどみは、完全にカットして表示することもできたが、あえて字幕では薄く表示して存在をさり気なく示した。これは丁寧なヒアリングから導き出されたユーザー視点の仕様だ。

音声自動字幕システム(左)と字幕表示イメージ(右)

「私たちからすると、『えー』『あのー』といったフィラーは邪魔なものでしかありません。しかし、なるべく情報を得たいというのが聴覚障がい者の方たちの本音でした。唇の動きを追いながら字幕を見ていくと、フィラーや言いよどみがカットされると『何かを言っているようだけど、字幕では表示されない』というストレスにつながります。

そこで、フィラーも言いよどみも字幕には残しつつ、薄めの表示にして読みやすさを考慮しました。記録として残す際は、これらのフィラー、言いよどみはカット。簡潔なドキュメントとして仕上げることができます」(芦川氏)

工場の現場でも真価を発揮! モノづくり視点のAIが見えた

2019年3月には株式会社ドワンゴの協力を得て、情報処理学会 第81回全国大会の模様をニコニコで生中継。リアルタイム字幕つきの動画がオンライン配信された。

開発チームは商用サービスとしての本格リリースに向けて精度、機能向上に余念がない。オフィスでの業務はもちろん、モノづくりの現場への展開も視野に入る。

「現在のオフィスにおいて、音声認識がサービスとして活用されるシーンはほとんどないのが現実です。ですから、ユーザーに信頼されて使われ、最終的には音声認識AIと意識することなく業務に使われるような存在になっていければ理想です。今、こうして話している言葉もそのまま、業務文書で使えるレベルのテキストになり、誰が発した言葉なのか、話し手の識別もしっかり記録される。そんな便利で頼れる音声認識AIを目指していければ」(芦川氏)

「音声認識が普及していないのは、モノづくりの現場でも同じです。しかし、保守点検や工場などでは、ハンズフリーで音声を収集して記録に残すというニーズは確実にあります。そこに、この音声認識AIは活躍できる余地があるのではないでしょうか。

現場の知見、ノウハウを生かしながら音声認識をシームレスに浸透させていく。これは長く音声認識を開発し、モノづくりやインフラの現場で知見を積み重ねてきたからこそできることでもあります。東芝でなぜ音声認識をやるのか? その根源的な問いへの一つの回答になると考えています」(藤村)

製造業に限らず、様々な業界で叫ばれる人手不足。2020年代にはいっそう労働力不足が深刻なものになっていくと見られる。作業量の低減による生産性の向上、そして聴覚障がい者の情報の垣根をなくす情報保障の拡充は喫緊の課題だ。オフィスで、そしてモノづくりの現場で、この音声認識AIが存在感を発揮するシーンは確実に増えていくに違いない。

![]()